Science/Research 詳細

新しいビジョンシステムで自分自身を知るロボット

August, 22, 2025, Cambridge--MIT CSAILの研究者によって開発されたNeural Jacobian Fields(NJF)は、他のセンサなしで、1台のカメラからあらゆるロボットを制御する方法を学習できる。

マサチューセッツ工科大(MIT)のコンピュータサイエンス・人工知能研究所(CSAIL)のオフィスでは、柔らかいロボットハンドが慎重に指を丸めて小さな物体をつかんでいる。興味深いのは、機械設計や埋め込みセンサではない。実際、手にはセンサは一切搭載されておらず、代わりに、システム全体がロボットの動きを監視し、その視覚データを使用してロボットを制御する単一のカメラに依存している。

この機能は、CSAILの科学者が開発した新しいシステムから生まれ、ロボット制御に新しい視点を提供する。手作業で設計したモデルや複雑なセンサアレイを使用するのではなく、ロボットは視覚のみを通じて、制御コマンドに体がどのように反応するかを学習できる。NJFと呼ばれるこのアプローチは、ロボットに一種の身体的自己認識を与える。この研究に関するオープンアクセス論文は、6月25日にNatureに掲載された。

「この研究は、ロボットのプログラミングからロボットの教育への移行を示している。今日、多くのロボット工学のタスクには、広範なエンジニアリングとコーディングが必要である。将来的には、ロボットに何をすべきかを示し、自律的に目標を達成する方法を学習させることを想定している」と、CSAIL所属でMIT電気工学・コンピューターサイエンスPh.D学生で、本研究の主任研究者であるSizhe Lester Liは話している。

その動機づけは、シンプルだが強力な再構築に由来する。手頃な価格で柔軟なロボット工学に対する主な障壁はハードウエアではなく、複数の方法で達成できる能力の制御である。従来のロボットは剛性が高く、センサを多く搭載して構築されているため、制御に使用される正確な数学的レプリカであるデジタルツインを簡単に構築できる。しかし、ロボットが柔らかく、変形しやすく、不規則な形状をしている場合、こうした前提は崩れる。NJFは、ロボットがわれわれのモデルに合わせることを強制するのではなく、その考え方を逆転させて、ロボットが観察から独自の内部モデルを学習できるようにする。

見て学ぶ

モデリングとハードウエア設計のこの分離により、ロボット工学の設計空間が大幅に拡大する可能性がある。ソフトロボットやバイオインスパイアードロボットでは、モデリングを可能にするためだけに、設計者がセンサを埋め込んだり、構造の一部を補強したりすることがよくある。NJFはその制約を取り除く。このシステムは、制御を可能にするためにオンボードセンサや設計の微調整を必要としない。設計者は、後でモデル化または制御できるかどうかを心配することなく、型破りで制約のない形態を自由に探索できる。

「指をコントロールする方法を考えてみる。小刻みに動かし、観察し、適応する。まさにそれがわれわれのシステムである。ランダムなアクションを実験し、どのコントロールがロボットのどの部分を動かすかを判断する」(Li)。

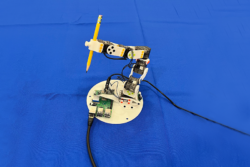

このシステムは、さまざまなタイプのロボットで堅牢であることが証明されている。チームは、つまんでつかむことができる空気圧式ソフトロボットハンド、剛性のあるアレグロ(Allegro)ハンド、3Dプリントされたロボットアーム、さらにはセンサが埋め込まれていない回転プラットフォームでNJFをテストした。いずれの場合も、システムはロボットの形状と制御信号にどのように反応するかの両方を、視覚とランダムな動きから学習した。

研究チームは、研究室をはるかに超えた可能性を見出している。NJFを搭載したロボットは、いつの日かセンチメートルレベルの位置特定精度で農業作業を実行したり、精巧なセンサアレイなしで建設現場で作業したり、従来の方法が機能しなくなった動的な環境をナビゲートしたりできるようになる。

NJFの中核となるのは、ロボットの具現化の2つの絡み合った側面、つまり3次元形状と制御入力に対する感度を捉えるニューラルネットワークである。このシステムは、空間座標を色と密度の値にマッピングすることにより、画像から3Dシーンを再構築する技術であるNeural Radiance Fields(NeRF)に基づいて構築されている。NJFは、ロボットの形状だけでなく、ロボットの体の任意の点がモーターコマンドに応答してどのように動くかを予測する関数であるJacobian場も学習することで、このアプローチを拡張する。

モデルをトレーニングするために、ロボットはランダムな動きを実行し、複数のカメラが結果を記録する。人間の監督やロボットの構造に関する事前の知識は必要なく、システムは監視することで制御信号と動きの関係を推測するだけである。

トレーニングが完了すると、ロボットは約12Hzで動作するリアルタイムの閉ループ制御のために1台の単眼カメラのみを必要とする。これにより、継続的に自分自身を観察し、計画し、応答性のある行動をとることができる。この速度により、NJFは、リアルタイムで使用するには計算量が多すぎることが多い、ソフトロボット用の多くの物理ベースのシミュレータよりも実行可能になる。

初期のシミュレーションでは、単純な2D指やスライダーでも、ほんの数例を使用してこのマッピングを学習できた。NJFは、特定の点が動作に応じてどのように変形または移動するかをモデル化することにより、制御可能性の密なマップを構築する。この内部モデルにより、データがノイズが多い場合や不完全な場合でも、ロボットの体全体の動きを一般化できる。

「本当に興味深いのは、どのモーターがロボットのどの部分を制御するかをシステムが独自に理解することだ。これはプログラムされたものではなく、人が新しいデバイスのボタンを発見するのと同じように、学習を通じて自然に現れる」(Li)。

未来はソフト

何十年もの間、ロボット工学は、工場で見られる産業用アームのような、剛性が高く、簡単にモデル化できる機械を好んできた。しかし、この分野は、現実世界により流動的に適応できる、柔らかいバイオインスパイアロボットに向かって進んでいる。トレードオフは?これらのロボットはモデル化が困難なことである。

「今日のロボット工学は、高価なセンサと複雑なプログラミングのために、手の届かないところに感じられることがよくある。NJFの目標は、障壁を下げ、ロボット工学を手頃な価格で適応性があり、より多くの人々が利用できるようにすることである。視覚は回復力があり、信頼性の高いセンサだ」と、上級著者でシーン表現グループを率いるMIT助教授のVincent Sitzmannは話している。「これは、農場から建設現場まで、高価なインフラなしで、乱雑で構造化されていない環境でも動作できるロボットへの扉を開く」。

「ビジョンだけで、位置特定と制御に必要な手がかりを提供できる。GPS、外部追跡システム、または複雑なオンボードセンサが不要になる。これにより、地図なしで屋内や地下を航行するドローンから、雑然とした家や倉庫で作業する移動式マニピュレータ、さらにはでこぼこした地形を横断する足のあるロボットまで、構造化されていない環境での堅牢で適応的な行動への扉が開かれる」と、共著者でMITの電気工学およびコンピュータサイエンス教授でCSAILのディレクターであるDaniela Rusは話している。「視覚的なフィードバックから学習することで、これらのシステムは独自の動きとダイナミクスの内部モデルを開発し、従来のローカリゼーション方法では失敗する柔軟な自己教師ありの操作を可能にする」。

現在、NJFのトレーニングには複数のカメラが必要であり、ロボットごとにやり直す必要があるが、研究チームはすでに、よりアクセスしやすいバージョンを構想している。将来的には、趣味でロボットのランダムな動きをスマートフォンで録画し、その映像を使って制御モデルを作成できるようになるだろう。出発前にレンタカーのビデオを撮るのと同じような感覚である。事前の知識や特別な機材は必要としない。

このシステムはまださまざまなロボット間で一般化されておらず、力や触覚センシングが欠けているため、接触の多いタスクでの有効性が制限されている。しかし、チームは、一般化の改善、オクルージョン(遮蔽)への対応、長期的な空間・時間推論能力の向上など、これらの制限に対処するための新しい方法を模索している。

「人間が自分の体がどのように動き、コマンドに反応するかを直感的に理解するように、NJFは視覚だけでロボットにそのような具現化された自己認識を与える。この理解は、現実世界の環境で柔軟な操作と制御を行うための基盤である。われわれの研究は、本質的に、詳細なモデルを手動でプログラミングすることから、観察と対話を通じてロボットを教える方向に移行するという、ロボット工学におけるさらなる広範な傾向を反映している」(Li)。