Science/Research 詳細

NTT、AIモデルの再学習コストを大幅に削減可能な過去の学習過程を再利用する「学習転移」を実現

May, 15, 2024, 東京--日本電信電話株式会社(NTT)は、深層学習において過去の学習過程をモデル間で再利用する全く新たな仕組みとして「学習転移」技術を実現した。

この技術は、ニューラルネットワークのパラメータ空間における高い対称性を活用し、過去の学習過程のパラメータ列を適切に変換することにより、新たなモデルの学習結果を低コストで求めることを可能にする。これにより、生成AIなど大規模な基盤モデルを用途毎に追加学習(以下、チューニング)して利用する場合に不可欠な、基盤モデルの定期的な更新に伴う再チューニングコストを大幅に削減でき、生成AIの運用容易化や適用領域拡大、消費電力の削減に貢献することが期待される。

研究成果は2024年5月7日から11日まで、オーストリア・ウイーンで開催される機械学習分野における最難関国際会議International Conference on Learning Representations (ICLR) 2024(*4)において発表される。

技術のポイント

ポイント① 学習転移の定式化

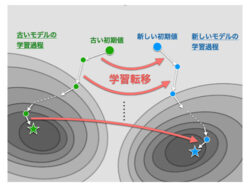

学習転移は、2つのパラメータ初期値が与えられたときに、一方の初期値に対する学習過程(ソース)を変換したときにもう一方の初期値の学習過程(ターゲット)との距離を最小化するような置換変換を求める、最適化問題として定式化された。このように2つの学習過程間の変換を最適化するという枠組み自体が、この研究により世界で初めて提案されたものになる。

ポイント② 高速なアルゴリズムの導出

上記の最適化問題に現れるターゲットの学習過程は、そもそも学習転移によって求めたかったものであり事前には未知であるため、そのままでは実際の計算機上で扱うことはできなかった。そこで学習過程の各ステップが勾配で近似できるという仮定を置くことで、実際に計算機で扱える非線形最適化問題を導出した。また非線形性のために、そのままでは効率的に解くことができなかったが、学習過程の部分的な転移と線形最適化とを交互に行うことにより、高速に解くことが可能となった。

ポイント③ 理論的分析

2層ニューラルネットワークの数理モデルにおいて、ネットワークサイズが大きくなればなるほど、最適な置換変換が高い確率で存在し、ソースの初期学習過程を変換することでターゲットの初期学習過程にいくらでも近づけられることを証明した。この結果は、ニューラルネットワークが大規模になるほど、実際に学習転移が可能となることを理論的に示している。

(詳細は、https://group.ntt/jp)