Science/Research 詳細

学習するインテリジェントカメラ

November, 17, 2020, Bristol--ロボット工学と人工知能(AI)研究者は、現在のシステムが世界を感知し、処理する方法に問題があることを知っている。現在、システムは、まだ画像を記録するデジタルカメラのようなセンサと、ビデオゲーム用のグラフィックスを加速するために設計されたGPUsのようなコンピューティングデバイスを統合している。

つまりAIシステムは、センサとプロセッサ間で視覚情報を記録、転送した後にのみ世界を感知する。しかし見える多くのものは、目の前の作業とは関係ないことがよくある。自律走行車が通り過ぎる際の道脇の木々の葉の細部などである。しかし、この情報のすべてがセンサで詳細に取得され、送られるときに、無関係なデータでシステムを渋滞させ、電力を消費し、処理時間を浪費する。インテリジェントマシーンで効率的な視覚を可能にするために別のアプローチが必要である。

ブリストル大とマンチェスター大が協力した2つの論文は、センシングと学習が統合されてAIシステム向けの新しいカメラを実現する方法を示している。

ブリストル大学、ロボット工学、コンピュータビジョン、モバイルシステム教授、主席研究者、Walterio Mayol-Cuevasは、「効率的な知覚システムを実現するために、われわれはこれまでに従ってきた方法の限界を超える必要がある」とコメントしている。

「われわれは、自然のシステムが視覚世界を処理する方法から創造性を借りることができる、われわれの目や脳は、協働して世界の意味を理解する、場合によっては、眼自体が処理して、関係ないものを脳が削減するのを助ける」。

これは、カエルの眼がハエのような物体を、画像が感覚された点ですぐさま見ぬ抜くディテクタをもっていることで証明されている。

ブリストル大学のDr Laurie BoseとYanan Liuによる論文は、この目標へ向けた2つの改善を明らかにしている。畳み込みニューラルネットワーク(CNNs)を直接画像プレーン実装する。チームが開発したCNNsは、1秒に数千回、フレームを分類できる。これらの画像を記録したり、処理パイプラインに送る必要はない。研究チームは、手書きの数字、手ぶれを分類、プランクトンさえ分類するデモンストレーションを考えた。

研究チームは、インテリジェント専用AIカメラの将来を示唆している。物体、あるいはカメラの前で起こっているイベントなど、ハイレベルの情報だけをシステムの残りに送ることができる視覚システム。このアプローチは、システムをはるかに効率的にし、セキュアにする。画像が記録される必要がないからである。

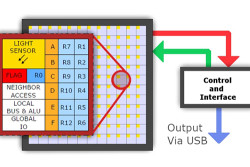

研究成果は、マンチェスター大学Piotr Dudek教授が開発したSCAMPアーキテクチャにより可能になった。SCAMPは、研究チームがPixel Processor Array (PPA)として記述しているカメラプロセッサチップである。PPAは、個々の、またすべてのピクセル内蔵のプロセッサであり、相互通信して真に並列形式で処理することができる。これは、CNNsとビジョンアルゴリズムにとって理想的である。

Dudek教授は、「ピクセルレベルでセンシング、処理、メモリを統合することは、高性能、低遅延システムを可能にするだけでなく、低消費電力、高効率ハードウエアを約束するものである」と話している。

「SCAMPデバイスは、現在のカメラセンサと類似のフットプリントで実装可能であるが、画像キャプチャ点で汎用大規模パラレルプロセッサを実行できる」。

ブリストル大学、飛行力学シニア講師、プロジェクトメンバー、Dr Tom Richadsonは、SCAMPアーキテクチャを軽量ドローンに組み込んだ。

「これらのカメラで非常に素晴らしいことは、新しいマシンラーニング機能だけでなく、その動作スピードと軽量構成である」と同氏は説明している。

(詳細は、https://www.bristol.ac.uk)