Pick up magazine feature 詳細

自動運転車

August, 6, 2021--より現実的な段階へとギアを上げる自動運転車の技術

ジェフ・ヘクト

フォトニック集積は、コストを削減し、自動運転車に必要なパフォーマンスを達成するための重要なテクノロジーとなった。

産業界において自動運転車はギアを一段と上げている。本田技研工業は2020年後半に、2021年3月に日本のレジェンドモデルにいわゆる「渋滞アシスト」を導入すると発表した。これは低速車線における自動運転であり、高速道路の走行がゆっくりになったときに自家用車の制御を運転者から引き継ぐ機能である。マニュアルによると、レーダーとカメラを使用して、道路がほぼ真っ直ぐで車線が検出できる限り、安全を保った距離で先行車を自動的に追跡する(1)。これにより、人間のドライバーは、高速道路の速度に達するまで走行の心配をする必要がなくなる。高速道路の速度に達すると、ドライバーは再びハンドルを握る必要がある。人間のドライバーによる制御手段を欠いているロボタクシーは、これよりも未来へと滑り込んでいる。

技術開発における大きなシフトは、自動運転システムの長距離トラックの制御への適用である。大きなトレーラートラックは道路で長時間を過ごし、通常、走行距離の約95%は、手入れが行き届き、アクセスが制限された高速道路である。これは自動運転車に向く適切に制御された環境である。開発者はさしあたって、高速道路を降りて倉庫に行く必要があるときや、道路の交通員が指示する一時的な迂回路などの複雑な状況に対応する必要があるときに、人間をトラックに乗せて運転することを想定している。完全なレベル4の自動運転は、技術が洗練され検証されるにつれ、あと数年で実現するだろう。大きなトレーラートラックは大きな投資であり、休憩や睡眠なしでロボットがまっすぐに運転可能にすることによる節約は、新技術の対価になる可能性がある。

自動運転へのでこぼこ道

これらの方向転換は、経済的及び技術的限界を部分的に反映しているが、最も重要な限界は人間のドライバーの能力かもしれない。開発者は当初、自動車の自律性が、補足(「運転自動化のレベル」を参照)に表示されるレベルを進むに従って、人間のドライバーからロボットへ制御をシフトすると想定していた。当初の目標はレベル3の自律性であり、ロボットが車を運転し、人間の運転手は道路に目を向け、ハンドルに手を添えて、必要に応じて警告なしに引き継ぐ準備をしておくというものだった。

しかし実際には、人は車を運転している時でも気が散りやすいものだ。車の運転を見ているだけとしても、目は道路に向くよりも携帯電話やその他の画面に向きがちである。前方を向いていなかったテスラのドライバーは、前方の道路を横断する青い空を背景にした白いトラックを車が認識できなかったために死亡した。米ウーバー・テクノロジーズ社(Uber Technologies)の車両は、夜間に自転車を押して道路を横切っている歩行者を認識できなかったため、死亡させた。制御が運転者に戻されたが、歩行者をはねた時、運転手はまさに電話から顔を上げたところだった。

これらの致命的な事故により、多くの開発者はレベル3は危険な段階だと考えている。多くの企業は、レベル2からレベル4に一気に引き上げることを期待されている。このためには、車が人間の助けなしにほとんどの条件を処理できることが必要である(2)。特に、道路に停車してライトを点滅させていた真っ赤な消防車に自動運転車が衝突するといった、致命的ではないもののばつの悪い事故が発生してから、一般市民も警戒を強めている。パンデミックは2020年初頭に開発にブレーキをかけたが、企業はすでに技術を洗練し、コストを削減するために開発を遅らせていた。

自家用車vs.ロボタクシー

米テスラ社(Tesla)は、2020年に、2019年に比べて35%増の約50万台の自家用車を納入した(3)。2019年3月以降のすべての「テスラ」にはオートパイロット機能が搭載されており、追加機能を提供するオプションとして、「フルセルフドライブ機能」と呼ばれる拡張ソフトウエアが利用可能である。追加機能の中には、車が高速道路の侵入車線から出口車線まで運転する機能、インターチェンジをナビゲートする機能、車線を変更する機能、正しい出口を出る機能などがある。ただし同社は、自動運転機能には「積極的なドライバーの監督が必要であり、車両を自動運転にしない」ことを強調している(4)。つまり、今までどおりドライバーには道路に目を向け、ハンドルに手を置くことが期待されている。

ホンダの渋滞のパイロットのように、テスラの制御システムはレーダーとカメラを使用して環境を感知するが、ライダは用いていない。2年前、テスラ社のCEOであるイーロン・マスク氏(Elon Musk)は、「ライダに依存すると破綻する」と宣言し、レーダーとカメラでナビゲーションに十分であると宣言した(5)。テスラ社が自動運転機能を備えた自家用車を販売して利益を上げるには、ライダは高すぎると言ったほうが適切かもしれない。

ホンダの渋滞アシストも同様の技術を使用しているとみられるが、車の走行速度が非常に遅い時に前方の車を追いかけるためのもので、重傷を負う可能性はほとんどない。マニュアルは注意深く、オートバイを追う時、料金所に入る時、または追いかけている車が別の車線に移動した時に正しく機能しないことを警告している。他にも、自家用車用に同様のシステムを開発した企業がある。

かつて米グーグル社(Google)の一部門だった米ウェイモ社(Waymo)、米ゼネラル・モーターズ社(General Motors)の自動運転車部門であるGMクルーズ(GM Cruise)、及びその他のサービスとして個人輸送を提供している企業によって開発されているロボタクシーの市場では話は変わる。これらの車両は、自家用車のようにガレージに収まっているのではなく、多くの場合道路上にあり、自動運転に必要なライダのコストを相殺するのに役立つ。レベル4の自動運転が望ましいとされる。しかし、これらの計画は遅れており、初期のパイオニアであるウーバー社は、12月に自動運転車グループを米オーロラ・イノベーション社(Aurora Innovation)に売却した(6)。

米ルミナー・テクノロジーズ社(Luminar Technologies)の共同創設者兼最高技術責任者であるジェーソン・アイヒェンホルツ氏(Jason Eichenholz)は、現在、真のレベル4の自律性を備えた車を提供しているところはないと述べている。ただし、2022年に、スウェーデンのボルボ社(Volvo)は、ルミナー社の「イリス(Iris)」1550nmライダと、スウェーデンのゼンセアクト社(Zenseact)の他のセンサ及び自動運転ソフトウエアを組み合わせた「ボルボ・ハイウェイ・パイロット(Volvo Highway Pilot)」と呼ばれるオプションシステムを搭載した車の提供を開始する。このライダは消費者向け車両において初になる。

アイヒェンホルツ氏は、ボルボ社の製品は高速道路では、レベル4の自律性を備えた「真の自動走行モード」システムになると述べている。高速道路は走行速度が速い場合があるが、環境は都市や郊外の道路よりもはるかに予測可能であり、交差点の通行や歩行者、信号機、自転車はない。高性能ライダを備えたレベル4の自律性は、高速道路環境内の物体を識別し、それらの周りを安全に操縦するための長い検出範囲と高いポイント密度を提供する。車の制御は他の環境では人に引き渡されるため、一般的なドライバーは車を自宅から高速道路に誘導し、車はそこから出口車線まで運転し、人間は高速道路を出て目的地まで運転するときに制御を再開する。

「時間の経過とともに、そのレベル4のエクスペリエンスの運用領域が拡大し、テクノロジーが向上するにつれて、より多くの運転エクスペリエンスをカバーできるようになる」とアイヒェンホルツ氏は言う。しかし、急速な移行を期待するべきではない。「すべての運用領域で完全に自動走行モードのレベル5に到達することは、非常に困難である」と彼は言う。「(道路の)99%のカバーを達成するのは簡単だが、規制当局はファイブナイン(99.999%)を望んでいる」。それには正当な理由がある。アメリカの田舎は、標識のない未舗装の道路でいっぱいだ。悪天候により、車の前後の視界が悪くなり、高速道路は滑りやすい状況に陥る可能性がある。

ロボトラックのブーム

テスラ社は、自家用車と同様に、自動運転機能を備えた大型トラックを最初に市場に投入することを目指している。同社は2021年1月、今年からテスラの自動車と同様の自動運転機能を搭載する「テスラ・セミ(Tesla Semi)」トラックの生産を開始すると発表した(7)。しかし、セミの主な焦点は、全電動化「ゼロエミッション」電力システムであるように思われる。このために、米ウォルマート社(Walmart)は2020年9月に130台のトラックを注文した(8)。

他の企業は、長距離トラックを自動運転車の当面における潜在的な最大の市場と見なしている。これは米国で年間8000億ドルの事業であり、州間高速道路における走行距離のほとんどを占める。トラック業界は、現在6万人のトラック運転手が必要であると述べており、ベテランドライバーが引退するにつれて不足が拡大し、自動運転が魅力的になると予想されている。ルミナー社は、独ダイムラー・トラック社(Daimler Trucks)及びその子会社の米トルク・ロボティクス社(Torc Robotics)と協力して、レベル4の自動運転トラックシステムを開発した。大きなトレーラートラックのサイズは、センサをより広いスペースに配置したり、他の自動化システムを搭載したりできるため利点がある。

自動運転車で使用されている多くの技術はトラックに移すことができる。ただし、米トゥーシンプル社(TuSimple)のチーフプロダクトオフィサーであるチャック・プライス氏(Chuck Price)は、「トラックのダイナミクスと機能的動作は乗用車のそれとは大きく異なる」と述べている(9)。トラックは大型荷物を満載し、高速道路では速度を出して走行しているため、安全に停止するには、はるかかなたから物体を検知して認識することが必要である。トゥーシンプル社は、昼夜、雨天あるいは晴天を問わず最大1000m離れた車両を識別できる10台の高解像度カメラをトラックに装備しており、他の車両を操縦したり、必要に応じて停止したりするための十分なスペースを提供する(図1)。5つのマイクロ波レーダーは最大300m離れた物体を検出及び識別できる。これは、霧や雨が視界を妨げる場合に重要である。ペアの200m範囲のライダは、その範囲内のオブジェクトの詳細なビューを提供する。

図1 トゥーシンプル社の自動運転トラックで使用される200m 範囲のライダ。これはトラクターユニットのボンネットの片側のヘッドライトの上部、少し後方に取り付けられている。2 つ目のライダは他方の上部にある。(画像提供:トゥーシンプル社)

これまでのところ、トゥーシンプル社は、アリゾナ州とテキサス州の間で人間のセーフティドライバーを乗せてトラックの試運転を行ってきた。今年のうちに、同社は積極的な人間の監督なしに自動運転モードでトラックを運転させることを計画しているが、セーフティドライバーとテストエンジニアはその性能を監視する車両にいる。トゥーシンプル社の目標は、高速道路の出口から少し離れた場所にあるターミナル間でレベル4の運転を実証することである。同社は、国際トラックメーカーである米ナビスター・インターナショナル社(Navistar International)と提携し、2024年までに高速道路用のレベル4の自動運転トラックの生産を開始することにしている。エンバーク・トラックス社(Embark Trucks)やウェイモ社(10)、プラス・テクノロジー社(Plus Technology)、オーロラ社などのシリコンバレーエリア企業を含む他のいくつかの企業も同様の計画を立てている。オーロラ社は、2020年12月にウーバー社の自動運転車グループを買収し、自動車の前にトラックに自動運転技術を導入することを計画している。

製造ニーズへの対応

フォトニクス業界にとって重要な課題は、自動車での使用に必要なサイズと規模で製造技術を構築することだとアイヒェンホルツ氏は言う。業界の要件は厳しい。−40℃から80℃温度に耐えられるものを手頃なコストで大量生産することが求められる。自動車の顧客は、新製品の安全性と品質をテストするための時間を必要とし、その後、生産ラインで新製品を入手するには数年を必要とする。

サプライチェーンの構築と生産の自動化には、人的リソースと資金的リソースが必要である。ルミナー社は、社内で製品を構築することから始め、その後、委託製造業者などとのパートナーシップを発展させた。同社は、チップレベルから構築し、ダイの配置、ワイヤボンディング、及びその他のステップを実行することから始めた。製品が進化するにつれて、特定用途向け集積回路(Application Specific Integrated Circuit:ASIC)により多くの機能を搭載してコストを削減し、パフォーマンスを向上させている。例えば、信号処理をASICに組み込んで、検出器へのワイヤボンドの静電容量やレーザ回路のインダクタンスを回避する。

同社のライダの専門知識は、1550nmパルスの飛行時間型(Time of Flight:ToF)ライダのトレードオフのバランスを取るのに役立った。アイヒェンホルツ氏は、「MEMSで発生する共振や温度の問題がなく、非常に信頼性が高い」ため、機械的スキャンを選択したと述べている。メカニカルポリゴンミラーは水平面で高速にスキャンする。ガルバノメーターは垂直方向にゆっくりとスキャンする。この技術は40年前にバーコードスキャナで使用されていたが、現在では大量生産において非常に費用対効果の高いものになっている。出力ビームと受信機の両方をスキャンすると、視野が非常に狭くなり、太陽やその他の光源からの干渉がブロックされる。

フォトニック集積は、ライダのコストとパフォーマンスの向上を約束する。ルミナー社は、ドライバー支援ライダのコストを500ドルに、自動運転車に必要なより精密なライダのコストを1000ドルに低減することに取り組んでいる(11)。以前の数万ドルのレベルからの大幅な引き下げであり、このことがボルボ社及びダイムラー・トラック社との取引につながるのに役立った。11月、米インテル社(Intel)の子会社であるイスラエルのモービルアイ社(Mobileye)は、ロボタクシー用の第1世代のレベル4自動運転システムにルミナー社のライダを選択した(12)。ルミナー社は、2010年にライダの提供を開始した米ベロダイン・ライダ社(Velodyne Lidar)や他のいくつかの企業とToFライダで多くの競争を繰り広げている。

競合するライダ技術

代替のライダテクノロジーも登場している。2021年1月、モービルアイ社は、インテル社で開発中の新しいチップスケール周波数変調連続波(FMCW)ライダに、2025年までに自動駆動システムの将来のバージョンを構築する計画を発表した(13)。

FMCWライダは、出ていくビームの周波数をチャープし、出ていく信号の一部とコヒーレントにリターン信号を混合する。周波数を比較することでターゲット距離が決まり、速度を直接測定できる。ToFシステムは速度を直接測定できない。支持者は、太陽光や他のライダからの干渉に対する相対的な耐性、高感度、低ピーク電力など、コヒーレントライダの他の利点を挙げている(14)。

インテル社のシリコンフォトニック製品部門のJ・K・ドイレント氏(J. K. Doylend)とS・グプタ氏(S. Gupta)は、SPIE Photonics West 2020において、範囲と速度の両方を直接検出するFMCWライダの機能が自動運転車にとって非常に魅力的であると報告した。パフォーマンスを実現するには、レーザ、増幅器、位相及び振幅制御、低ノイズ光検出器、モードコンバータ、導波路などの光学系の高密度の統合が必要であったが、統合により、コンパクトなライダを大量に生成できる(15)。

現在のライダシステムは、カメラ、ToFライダ、レーダーからの情報を組み合わせて車両を操縦する。モービルアイ社の新しいシステムは、FMCWライダデータをレーダーと組み合わせて1つの表示チャネルを作成し、カメラデータを使用して2番目の独立したチャネルを作成する。モービルアイ社のCEOであるアムノン・シャシュア氏(Amnon Shashua)は、1月のバーチャルConsumer Electronics Show(CES)において、この組み合わせにより、2025年に商用バージョンが登場したときに安全性とパフォーマンスが向上すると考えていると述べている(16)。

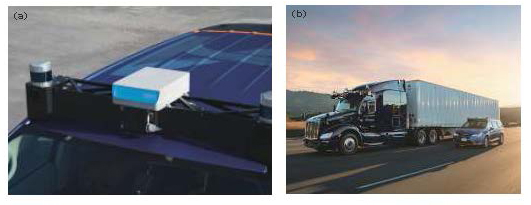

オーロラ社は、米インサイト・ライダ社(Insight Lidar)のFMCWライダを、開発中の自動運転トラックですでにテストしている(図2)。FMCWライダは、高速道路の速度で必要とされる長距離検出に重要な、長距離検出範囲と高感度を提供するとインサイト社の事業開発担当副社長であるグレッグ・スモルカ氏(Greg Smolka)は述べている。彼らは、2023年までに初期バージョンを使用し、2025年までに大量に使用、2026年に自動運転車での製品化を目指している。

図2 (a)「オーロラ・ファーストライト・ライダ(Aurora Firstlight Lidar)」は、「オーロラ・パシフィック(Aurora Pacific)」自動運転車の前面に取り付けられている。(b)オーロラ社は、パシフィックカーと自動運転トラックの自動運転システムで同様のライダを使用している。ライダはフロントガラスの上のセンサバーの中央にあり、他のセンサは左右にある。(画像提供:オーロラ社)

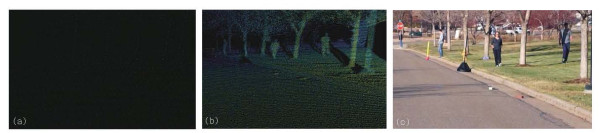

スモルカ氏は、リターンごとに速度を直接検出することで、FMCWライダが物体の識別や速度の測定に役立つと述べている。「トラックを追い越すオートバイの画像は同じ範囲にあるため、カメラ内で一緒にぼやけることがあるが、データに速度がある場合、2つは簡単に区別される」と彼は言う。すべてのピクセルで速度を設定することで、レベル4及び5の自動運転に必要なパフォーマンスレベルを満たすことが難しい「エッジケース」の解像度を向上させることができる(図3)。

図3 (a)低解像度(0.2°×0.2°)の従来のライダ。オブジェクトを区別するのは困難である。(b)Insightの超高解像度(0.025°×0.025°)ライダ。道路にあるレンガと歩行者がはっきりと見える。(c)シーンのカメラ画像。(画像提供:インサイト・ライダ社)

別のFMCWメーカーである米エイバ社(Aeva)によると、ライダの範囲は300mで、すべての範囲で高いピクセル密度があり、120°×30°の視野が利用可能になっている。1月、同社はトゥーシンプル社とのパートナーシップを発表し、レベル4の自動運転トラックに「4D」ライダを配備した。

もう1つの潜在的な競合相手は、本来ドッキングまたは着陸する宇宙船の可動部品を回避するために開発されたフラッシュライダである。レーザパルスはさまざまな角度に広がり、レシーバー光学系の焦点は2次元の検出器アレイに戻る。返された信号を処理すると、3次元の点群が生成され、戻り時間から距離が収集される。単純であるという利点があるが、パルスエネルギーが広範囲に分散すると受信電力が制限され、通常は範囲が100m未満に制限される(17)。

将来の展望

自動運転車は過去数年間で驚くべき進歩を遂げたが、課題は残っている。

ライダは、自動運転のニーズを満たすために、いくつかの技術的な問題を解決する必要がある。もっとも重要なのは、ライダの範囲と、離れた場所で測定できる点群の密度との間の固有のトレードオフである。ライダは、数十メートル離れたオブジェクトのマッピングに非常に優れているが、点の間隔は距離とともにさらに離れて広がる。100mでは、0.025°間隔で配置された点は8.7cm離れている。それでは歩行者が通りを横断しようとしているのか、反対方向を見ているのかを判断するのに十分な点を歩行者に与えることはできない。光が往復するためには、ライダパルスを遠くに離す必要があるため、光の速度でさえ問題になる。200mのオブジェクトの場合は1.3μs、繰り返し率は77万Hzに制限される。

自動運転と道路環境で使用される技術には別な課題を提起するものもある。異常で予期しない事柄もそうだ。自動運転車が、風に吹かれているバッグではなく、バッグを持つ人のために急ブレーキをかけることを期待できるだろうか。

フォトニック集積と優れたエンジニアリングは、これらの課題を克服するのに役立つ。(人工知能にも役立つ可能性がある。今後の記事に注意されたい。)また、制限を受け入なければならない。私は長いことニューイングランドに住んでいるが、学んだことは、悪天候を乗り切る最善の方法は、それが過ぎ去るのを待つということだ。

運転自動化のレベル

レベル0:自動化なし(フォードモデルT、スティックシフト1957年式シボレー)レベル1:最小限の自動化(オートマチックトランスミッション、クルーズコントロール)

レベル2:ドライバー支援(バックカメラ、レーンモニター、衝突警告)人は道路に目を向け、ハンドルを握って運転する。

レベル3:必要に応じて即座に引き継げるよう人の監視の下で自動化。人の運転者は状況を十分に認識している。

レベル4:完全な自律性があるが、どこでも運転することはできず、必要に応じて人が乗車。安全な制御に移行している間は、人は昼寝をすることができる。

レベル5:完全に自律的で、どこにでも行くことができる。車に人は必要ない。

参考文献

(1)http://bit.ly/HechtAVRef1.

(2)“SAE selfdriving levels 0 to 5 for Automation: What they mean,” Autopilot Review; http://bit.ly/HechtAVRef2.

(3)http://bit.ly/HechtAVRef3.

(4)http://bit.ly/HechtAVRef4.

(5)T. B. Lee, “Elon Musk: Anyone relying on lidar is doomed. Experts: Maybe not,” Ars Technica(Aug. 6,2019); http://bit.ly/HechtAVRef5.

(6)S. Szymkowski, “Uber ditches selfdriving car plans, sells business to Aurora”(Dec 12,

2020); http://bit.ly/HechtAVRef6.

(7)http://bit.ly/HechtAVRef7.

(8)http://bit.ly/HechtAVRef8.

(9)E. Ackerman, “ This year, autonomous trucks will take to the road with no one on board, ” IEEE Spectrum(Jan. 4,2021); http://bit.ly/HechtAVRef9.

(10)http://bit.ly/HechtAVRef10.

(11)http://bit.ly/HechtAVRef11.

(12)“Mobileye selects Luminar lidar for autonomous vehicle pilot,” Optics.org(Nov. 24 , 2020); http://bit.ly/HechtAVRef12.

(13)“Intel’s Mobileye outlines auto lidar plan,” Optics.org(Jan 13, 2021); http://bit.ly/

HechtAVRef13.

(14)J. Hecht, Laser Focus World, 55, 5, 22-25(May 2019); http://bit.ly/HechtAVRef14.

(15)J. K. Doylend and S. Gupta, Proc. SPIE, 11285, 112850J(Feb. 26, 2020); doi:10.1117/12.2544962.

(16)http://bit.ly/HechtAVRef16.

(17)Y. Li and J. IbanezGuzman, IEEE Signal Processing Magazine, 37, 4, 5061(Jul. 2020); doi:10.1109/msp.2020.2973615.