Business/Market 詳細

AIデータセンタで液体冷却拡張、2025年に30%を超える普及率

September, 1, 2025, Taipei--TrendForce の液冷業界に関する最新の調査によると、2025 年に NVIDIA の GB200 NVL72 ラック サーバが展開されて、AI データセンタのアップグレードが加速され、初期のパイロット プロジェクトから大規模展開まで液冷の採用が促進されることが明らかになった。

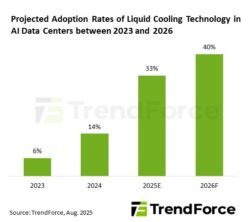

AI データセンターの普及率は、2024 年の 14% から 2025 年には 33% に急増すると予測されており、その後も成長が続く。

TrendForceは、AIサーバにおけるGPUとASICチップの消費電力が急激に上昇していると指摘している。たとえば、NVIDIA の GB200/GB300 NVL72 システムの TDP はラックあたり 130 ~140 kW で、従来の空冷システムの限界をはるかに超えている。これにより、液対空 (L2A) 冷却技術の早期導入が促進された。

L2A は、既存のデータセンタ インフラストラクチャと水循環システムの制約により、短期的には主流の移行ソリューションとして機能する。しかし、2025 年から次世代データセンタが稼働し、AI チップの消費電力とシステム密度が上昇し続けるにつれて、液対液 (L2L) 冷却は 2027 年から急速に普及し、より高い効率と安定性を提供すると予想される。時間が経つにつれて、L2L は AI 施設における主要な冷却ソリューションとして L2A に取って代わる見込みである。

北米の大手CSPs 4社はAIインフラへの投資を強化しており、北米、欧州、アジアで新たなデータセンタの拡張が進められている。CSPsは、液冷対応設計の施設も構築している。

Google と AWS はすでに、オランダ、ドイツ、アイルランドで液体冷却パイプラインを備えたモジュール式データセンタを立ち上げている。一方、Microsoftは米国中西部とアジアでパイロット展開を実施しており、2025年から液体冷却を標準アーキテクチャにする計画である。

TrendForce は、液体冷却の台頭により、冷却モジュール、熱交換システム、および関連コンポーネントの需要が高まっていると指摘している。コールドプレートは、直接接触熱交換のコアコンポーネントとして、Cooler Master、AVC、BOYD、およびAurasから供給されている。これらのサプライヤーのうち3社(BOYDを除く)は、米国のCSP顧客からの強い需要に応えるため、東南アジアの液冷生産能力を拡大した。

熱伝達と冷却水の流れを担うコアモジュールであるクーラント分配ユニット(CDU)は、一般にサイドカー設計とインロー設計に分類される。現在、Delta が主導するサイドカー CDU が市場を支配しているが、主に Vertiv と BOYD が供給するインロー CDU は、高密度 AI ラックの展開に適したより強力な冷却性能を提供する。

クイック ディスコネクト (QD) は、液体冷却システムの重要なコネクタであり、気密性、耐圧性、信頼性を確保する。NVIDIA の GB200 プロジェクトでは、CPC、Parker Hannifin、Danfoss、Staubli などの国際的なリーダーが、実績のある認定資格とハイエンド アプリケーションの専門知識により、早期に優位に立っている。