Science/Research 詳細

フォトンベース処理ユニットで複雑な機械学習が可能に

September, 2, 2020, Washington--ニューラルネットワークによるマシンラーニングは、人工知能開発への人気のあるアプローチである。研究者は、様々なアプリケーションに向けて脳の機能を複製することを狙っている。

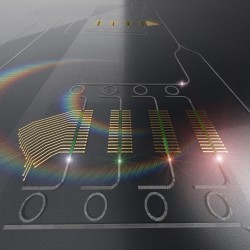

Applied Physics Reviewsの論文は、電気の代わりに光を使い、ニューラルネットワークが必要とする計算を実行する新たなアプローチを提案している。このアプローチでは、フォトンテンソルコアが、並列で行列の乗算を行い、現在のディープラーニングパラダイムのスピードと効率を改善する。

マシンラーニングでは,ニューラルネットワークを訓練して、初見のデータで教師なしの決定や分類を行えるようにする。ニューラルネットワークがデータで訓練されると、物体やパタンを認識し分類し、データ内の特徴を見つけ出すために推論が行える。

フォトニックTPU(tensor processing unit)は、並行してデータを蓄積、処理し、電気-光相互接続が特徴。これにより、光メモリは効率よく読み、書きでき、フォトニックTPUは他のアーキテクチャと接続する。

「効率的な光メモリを集積した集積フォトニックプラットフォームは、テンソル処理ユニット(TPU)として同じ演算をすることができるが、電力消費はわずかであり、スループットは高い。また、適切に訓練されると、光の速度で推論するために利用できるようになる」と著者の一人、Mario Miscuglioは説明している。

ほとんどのニューラルネットワークは、人の脳を真似る目的で相互接続されたニューロンの多重層を解明する。これらのネットワークを表す効率的な方法は、行列とベクトルを同時に乗算する合成関数である。この表示により、行列の乗算など、ベクトル化演算に特化したアーキテクチャを通した並列演算の実行ができる。

しかし、タスクがますますインテリジェントになり、望む予測の精度がどんどん高くなると、ネットワークはますます複雑になる。そのようなネットワークでは、計算のためのデータ量が多くなり、そのデータを処理するパワーも多くなる。

ディープラーニングに適した現在のデジタルプロセッサ、GUIあるいはTPUは、より高精度に複雑な演算を行うには、それを実行するパワー、プロセッサとメモリ間の遅い電子データ転送によって制約されている。

研究チームは、そのTPUの性能が,電子TPUよりも2 – 3桁高くなることを示した。5Gなど、ネットワークエッジでノード分散ネットワークの計算、インテリジェントタスクを高スループットに実行するエンジンにフォトンは、理想的な組合せである。ネットワークエッジでは、監視カメラ、光センサおよび他のソースからフォトンの形のデータ信号は、すでに存在するかも知れない。

「フォトニック特殊化プロセッサは、膨大な量のエネルギー節約となり、反応時間を改善し、データセンタトラフィックを減少させる」(Miscuglio)。

エンドユーザにとっては、データ処理が遙かに高速になる。データの大きな部分が、予め処理されているからである。つまり,データのほんの一部がクラウドあるいはデータセンタに送られるだけでよいことになる。

(詳細は、https://publishing.aip.org/)