Science/Research 詳細

隠れニューラルネットワーク理論を具現化したAIチップを世界で初めて開発

March, 1, 2022, 東京--東京工業大学 科学技術創成研究院の劉載勲准教授、本村真人教授らは、末端(エッジ)機器でのAI応用の発展に向けて今後さらに重要となる、深層ニューラルネットワーク(DNN)の高効率な推論を実現する新規アクセラレータLSI[用語1]を開発した。

これまでDNN推論アクセラレータLSIを自動車などのエッジ機器に搭載・応用するとき、外部メモリアクセス時の電力消費の大きさが課題とされてきた。

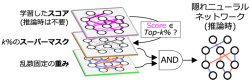

研究ではDNNの重み係数が乱数で固定されている「隠れニューラルネットワーク(Hidden Neural Network)[2020年の論文「What’s Hidden in a Randomly Weighted Neural Network?」にて発表された新しいDNN理論]」理論と呼ばれる新たなDNN理論に着目し、推論に必要な情報量と計算時の消費電力を大幅に低減する新規ハードウェア・アーキテクチャ「ヒデナイト(Hiddenite)」を世界で初めて考案した。新提案のオンチップモデル構築(On-chip Model Construction)技術によって、外部メモリアクセスを大幅に削減できることが大きな特徴である。さらに、このアーキテクチャに基づくアクセラレータLSIを製作し、世界最高レベルの高計算効率(最大34.8 TOPS/W)と、省モデルサイズDNNとして最高水準の推論精度(ImageNet70.1%)の両立ができることを実測結果で示している。

研究成果の詳細は「ISSCC2022(国際固体素子回路会議)」にて発表された(発表者:廣瀬一俊 博士後期課程3年)。

(詳細は、https://www.titech.ac.jp)