Science/Research 詳細

ロボット義肢向けにAIにコンピュータビジョン、不確かさを導入

June, 25, 2020, Raleigh--NC Stateの研究者は、既存のハードウエアと統合できる新しいソフトウエアを開発した。これにより、義肢あるいは外骨格(エクソスケルトン)を使う人々は、さまざまな種類の地形を安全に、より自然に歩くことができるようになる。新しいフレイムワークは、コンピュータビジョンを義脚制御に組込み、ソフトウエアが不確実性をうまく説明できるロバストな人工知能(AI)アルゴリズムを搭載している。

「ロボットの下肢は、ユーザが歩いている地形に基づいて様々な動作を実行する必要がある。われわれが作成したフレームワークにより、ロボット義肢のAIが、ユーザが踏み出そうとしている地形の種類を予測し、その予測に関連する不確実性を定量化し、次にその不確実性を意思決定に組み込む」とNC Stateの電気コンピュータ工学准教授、Edgar Lobatonは説明している。

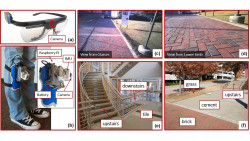

研究者は、ロボットの義肢で調整が必要とされる6つの異なる地形を区別することに焦点を当てた。タイル、ブロック、コンクリート、草、「上り」と「下り」。

「不確実性の程度が高すぎると、AIは、問題のある決定を強制されない。その代わりに、ユーザに、その予測の実行に自信がないことを告げる。あるいは、履行しないで安全モードにとどまる」と論文の筆頭著者、Boxuan Zhongは話している。

新しい「環境状況」フレームワークは、ハードウエアとソフトウエア要素の両方を含んでいる。:研究チームは、あらゆる下肢ロボット外骨格、またはロボット義肢デバイスで利用するためにそのフレームワークを設計したが、さらに追加のハードウエア、カメラもある。研究では、チームはメガネに取り付けたカメラや下肢そのものにマウントしたカメラを使った。チームは、両タイプのカメラからのデータを個別にまた統合して、AIがどのように利用できるかを評価した。

「コンピュータビジョンをウエアラブルロボットの制御ソフトウエアに組み込むことは、研究の新たな領域である。われわれは、両方の機能良好なカメラを使うが、消費電力が大きくなり、桁違いのコストがかかることを確認した。しかし、下肢に搭載したカメラだけを使うと機能は非常に優れており、特に目先の予測、次の一歩、二歩で地形はどうなっているかなど」とHuangは説明している。

しかし、最も大きな進歩は、AIそのものである。

「われわれは、不確実性の評価と定量化の仕方をディープラーニングに教える改善された方法を考案した。システムが不確実性をその意思決定に組み込むことができるような方法である。これは、ロボットの義肢に関連していることは確かであるが、ここでのわれわれの研究は、どんな種類のディープラーニングシステムにも適用可能である」(Lobaton)。

AIシステムを訓練するために、研究チームはカメラを健全な身体の個人に接続した。次に、様々な屋内、屋外環境を歩いてもらった。次に、チームは、下肢を切断した人にカメラを着け、同じ環境を移動してもらうことで概念実証評価を行った。

「そのシステムは、さまざまな被験者で機能するように適切に移行可能であることを確認した。つまり、それは一つのグループの人々で訓練し、異なる別の人で利用されたとは言え、AIは良好に機能したということである」。

とは言え、その新しいフレームワークは、まだロボットでテストしていない。

「次のステップでは、動いているロボットの義肢向けの制御システムにそのフレームワークを組み込む」。

「また、そのシステムのさらなる効率化にも取り組む。必要な視覚データ入力、データ処理を少なくすることである」とZhongは話している。

(詳細は、https://news.ncsu.edu)