Science/Research 詳細

AIコンピューティング効率を高めるチップ

November, 4, 2022, Stanford--スタンフォードのエンジニアは、より効率的で柔軟なAIチップを作製した。こはAIのパワーを微小なエッジデバイスに持ち込むことができる。

AI活用エッジコンピューティングは、われわれの生活ですでに普及している。ドローン、スマートウエアラブル、産業用IoTセンサなどのデバイスは、AI活用チップを搭載している。コンピューティングが、データが発生する、インターネットのエッジで起こるようにするためである。これによりリアルタイム処理やデータのプライバシーが保証される。

しかし、これら微小エッジデバイスのAI機能は、バッテリが供給するエネルギーに制約されている。したがって、エネルギー効率改善が極めて重要である。今日のAIチップでは、データ処理とデータストレージが、別の場所で起こる、計算ユニットと記憶ユニットである。これらユニット間の頻繁なデータの移動が、AI処理中のほとんどのエネルギーを消費するので、データの移動が、エネルギー問題対処のカギとなる。

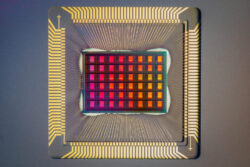

スタンフォード大学のエンジニアは、潜在的なソリューションを考えついた。メモリ内部でAI処理を行う新しい抵抗ランダムアクセスメモリ(RRAM)チップである。これによりコンピュートとメモリユニット間の分離がなくなる。その「コンピュート・イン・メモリ」(CIM)チップは、NeuRRAMと言い、爪先程度のサイズで、現在のチップの仕事と比較して、限られたバッテリパワーで、さらに多くの仕事をする。

「情報をクラウドとやり取りする代わりにチップでそのような計算が行われると、将来に向けてより高速、安全、安価、スケーラブルなAIとなり、AIパワーにアクセスする人が多くなる」と工学部、Willard R. and Inez Kerr Bell教授、H.-S Philip Wongは、説明している。

「データの移動問題は、2時間の就業時間のために通勤に8時間かけるのと同じである。われわれのチップで、この課題に取り組む技術を示している」と、このプロジェクトを主導するスタンフォード院生、Weier Wanはコメントしている。

研究チームは、NeuRRAMをNature誌に発表した。CIMは、数10年前からあるが、このチップは、シミュレーションのみではなく、実際に幅広い範囲のAIアプリケーションをハードウエアで初めて実証した。

計算パワーをデバイス上に

データ移動のボトルネック克服のために研究チームは、コンピュート・イン・メモリ(CIM)として知られること、新しいチップアーキテクチャを実装した。これは、AIコンピューティングを分離したコンピューティングユニットではなくメモリ内で直接実行する。NeuRRAMが使うメモリ技術は、抵抗ランダムアクセスメモリ(RRAM)。それは一種の非揮発性メモリ、パワーがOFFになってもデータを保持するメモリであり、市販製品に存在する。RRAMは、小さなフットプリントエリアに大きなAIモデルを蓄積でき、消費電力は極めて少ないので、小サイズ、ローパワーエッジデバイスには理想的である。

CIMチップのコンセプトが十分に確立されているとしても、RRAMにおけるAIコンピューティングの実行は新しくない。「これは、多くのメモリをニューラルチップに組み込み、ハードウエア計測を通じて全てのベンチマーク結果を示す初のものである」とWongは言う。同氏は、Nature論文の共著者

NeuRRAMアーキテクチャによりチップは、ローパワー、コンパクトエリアフットプリントで、インメモリ計算でアナログ動作する。それは、UC San DiegoのGert Cauwenberghsラボと協働するように設計されていた。同氏は、ローパワーニューロモルフィック(神経形態学的)ハードウエア設計の先駆者。そのアーキテクチャは、データフロー方向の再設定を可能にし、様々なAIワークロードマッピング戦略をサポートする。また、さまざまな種類のAIアルゴリズムと協働可能である。すべて、AI計算精度を犠牲にすることはない。

NeuRRAM AI機能の正確さを示すためにチームは、それが様々なタスクでどう機能するかをテストした。MNISTデータセットの文字認識では99%の正確さ、CIRAR-10データセットからの画像分類では85.7%の正確さ、Googleスピーチコマンド認識では84.7%、Bayesian画像回復タスクで画像再建の誤りでは70%低減を示した。

「効率、多様性、精度は、その技術のより広い適用にとって全て重要な側面である。しかし、その全てを同時実現することは容易ではない。ハードウエアからソフトウエアまでのフルスタック最適化がカギである」(Wan)。

「そのようなフルスタック共設計は、多様な専門技術を持つ国際的研究チームによって可能になる」とWongは付け加えている。

未来エッジコンピューティング促進

現在、NeuRRAMは、物理的な概念実証であるが、それが実際のエッジデバイスに移転されるまでにさらなる開発が必要である。

しかしこの統合された効率、正確さ、多様なタスク実行能力は、そのチップの潜在性を示している。「恐らく、今日、それはキーワード探索、人の発見などの単純なAI作業実行に使えるが、将来は、全く異なるユーザエクスペリアンスを可能にする。全て微小なデバイス内で、スピーチ認識と組み合わせたリアルタイムビデオ分析を想像してみる。これを現実にするには、われわれは継続して設計を改善し、RRAMをさらに先進的な技術ノードにスケールする必要がある」(Wan)。

「この研究は、RRAMデバイスエンジニアリング、コンピュータ・イン・メモリのためのプログラミングモデルやニューラルネットワークデザインについての将来の研究に複数の道を開き、この技術をソフトウエア開発者が拡張し、使えるようにする」と電気工学教授、論文の共著者、Priyanka Rainaはコメントしている。

もし成功すれば、NeuRRAMのようなコンピュータ・イン・メモリチップは、ほぼ無限の可能性を持つことになる。

量産になると、これらのチップは、十分に安価に、適用可能になり、すでにわれわれの生活を改善して照る技術を進歩させることができるローパワーになる。過程での健康モニタリング医療デバイスのようにである。

(詳細は、https://news.stanford.edu)