Science/Research 詳細

ロボットに人のような物理環境の知覚を付与

August, 28, 2020, Northbrook--MITの研究者は、ロボットが、もっとホームヘルパーのようになり、ハイレベルのコマンド、「キッチンへ行ってコーヒーカップを持ってきてくれ」などができるようになることを考えている。

そのようなハイLevelタスクを実行するためには、ロボットは人と同じように物理的環境を理解できなければならないと研究者は考えている。

「世界で決定を下すには、周囲環境のメンタルモデルを持つ必要がある。これは人間には、大した話ではない。しかしロボットにとっては、かなり難しい問題である。つまりカメラを通して見るピクセル値を世界の理解に変換することになる」とMITのLuca Carlone准教授は話している。

研究チームは、人が世界を知覚し、ナビゲートする方法にしたがってモデル化したロボットにとっての空間認識の表出を開発した。

その新しいモデルは、3D Dynamic Scene Graphsと言うもので、これによってロボットは、その周囲環境の物体や意味的ラベル(例えば、椅子 に対比したテーブル)、ロボットがその環境で見ると思われる人や部屋、壁、他の構造を含む3Dマップを素早く生成できる。

そのモデルによりロボットは、3Dマップから関連情報を引き出し、物体や部屋の位置あるいは、その経路内の人の動きを問うことができる。

「環境のこの圧縮表現は有用である。それにより、われわれのロボットが素早く決断し、その経路を計画できるからである。これは、われわれ人間がすることからあまりかけ離れていない。もし自分の家からMITまでの経路を計画する必要があるなら、通らなければならないすべてのシングルポイントを計画しない。通りとか目印レベルで考えるだけである。それがより素早くルートを計画するのに役立つ」とCarloneは説明している。

家庭のヘルパーの域を超えて、Carloneによると、この新しい種類の環境のメンタルモデルを採用するロボットは、他のハイレベルの仕事、例えば、工場フロアで人と並んで作業する、災害現場で生存者を探査するなどに適している。

MITの院生、論文の筆頭著者、Antoni Rosinolを含め、チームは、研究成果をRobotics: Science and Systemsバーチャル会議で発表した。

マッピングミックス

現在のところ、ロボットの視覚とナビゲーションは、主に2つのルートに沿って進歩した。3Dマッピングによりロボットは、3次元で、探査する環境をリアルタイムで再構築できる。また、意味的区分、これはその環境でロボットが特徴を意味的対象して分類するのに役立つ、例えば自転車と対比した自動車、これはこれまでは主に2D画像で行われている。

研究チームの新しい空間知覚モデルは、環境の3Dマップをリアルタイム生成する初のものであり、同時に対象、人々(物体に対して、動的)、その3Dマップ内の構造にラベルづけする。

チームの新しいモデル重要要素は、Kimeraである。これは、チームが以前に開発したオープンソースライブラリで、環境の3D幾何モデルを同時に構築し、併せて物体が、机に対して椅子などである可能性をエンコードする。

「様々な動物の混合である神話的か物のように、われわれはKimeraが、マッピングと3Dの意味的理解の混合となると考えた」(Carlone)。

Kimeraは、ロボットのカメラからの画像の流れ、オンボードセンサからの慣性計測を取込みことで機能する。これによりロボット、つまりカメラの軌跡を推定し、シーンを3Dメッシュとして再構成する。全てリアルタイムに行われる。

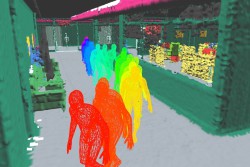

意味的メッシュを生成するために、Kimeraは、数百万の実世界画像で訓練された既存のニューラルネットワークを利用し、各ピクセルのラベルを予測する。次に、レイキャスティングとして知られる技術(リアルタイム表現のためにコンピュータグラフィックスで一般に使われている)を使いこれらのラベルを3Dで投影する。

結果は、ロボットの環境のマップである。これは、高密度3Dメッシュのようであり、個々の外見が、環境内の物体、構造、人々の一部として色づけされている。

層状場面

ロボットが、このメッシュだけに依存して、その環境をナビゲートするなら、コンピュータ滴には高価で時間のかかるタスクになる。したがって、研究チームは、Kimeraから離れて、Kimeraの最初の高密度、3D意味的メッシュから3D動的「シーングラフ」を構築するアルゴリズムを開発した。

シーングラフは、一般的なコンピュータグラフィックスモデルであり、複雑な場面を操作し、表現する、また3D環境を表すためにビデオゲームエンジンで一般的に使われている。

3D動的シーングラフの場合、関連するアルゴリズムが抽象的、つまり、Kimeraの細部3D意味的メッシュを明確な意味的そうに分解する。ロボットが特殊な層、つまりレンズを通して情景を「見る」ことができるようにである。レイヤは、物体と人々から、オープンスペースや構造、例えば、壁や天井、部屋、廊下、ホール、最終的に建物全体までの階層で発展する。

Carloneによると、層状表現は、元の3Dメッシュで数十億の点と顔をロボットが認識しなくてもいいようにする。

物体や人々のレイヤ内に、、チームは環境における人の動きや形状をリアルタイムで追跡するアルゴリズムを開発することができた。

チームは、MIT Lincoln Laboratoryと共同開発したフォトリアリスティックシミュレータで、その新しいモデルをテストした。これは、動き回る人々で満たされている動的オフィス環境をナビゲートするロボットをシミュレートする。

Carloneは、「われわれは、基本的に、ロボットが人が使うのと同じメンタルモデルを持つようできる。これは多くのアプリケーションに良い影響を与える。自動運転車、捜索やレスキュー、共同製造、家庭ロボットが含まれる。もう一つの領域はVRとAR。われわれのアルゴリズムを走らせるARゴーグルをかけていると考えると、そのゴーグルは、‘赤いマグカップをどこに置いた?’また、 一番近い出口はどこ? などの問いで、助けてくれる。周囲環境を認識しており、物体、人、その関係を理解しているAlexaとして、それを考えることができる」。

「われわれのアプローチは、ディープラーニングの最近の進歩、数十年に及ぶ同時局所化とマッピングにより可能になった」とRosinolは言う。「この研究で、われわれは、いわゆる空間-AI、ロボット知覚の新時代へ飛躍する。空間-AIは、初期段階に過ぎないが、ロボット公眼や大規模VR、ARで大きな可能性がある」。

(詳細は、https://news.mit.edu)